|

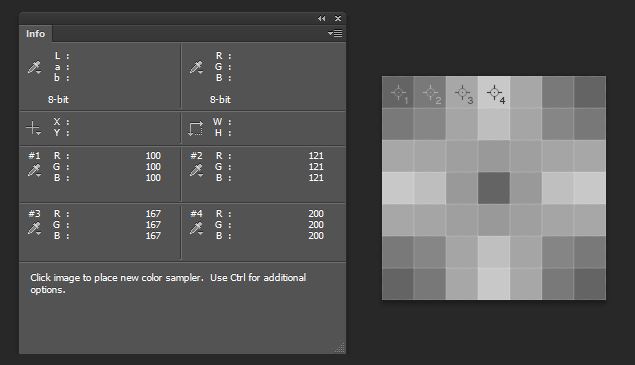

| az1-es és 4-es mérések a kiinduló pixelértékek, X a kettes, Y a hármas. |

2020/10/30

A Sampling Lánczos kutyái, Bilineár és Bikubik,megvesztek?

2020/10/20

Először volt a bugyi, most meg a maszk! Mi lesz a következő???

Ki tiltja meg, hogy elmondjam, mi bántott hazafelé menet? (JA)

Tetszik, nem tetszik, az emberi test is anyagot ken szét maga körül, mint a csiga, különféle hulladékokat, váladékokat hagy maga után, és az, hogy ez másoknak izgalmas, vagy undorító, esetleg közömbös, vagy az egészségére ártalmas, az helyzetfüggő. Van akit undorít mások hámló bőre, és van aki szívesen nyomogatja mások pattanásait is. Szóval nem vagyunk egyformák. És nem is mindig zavar, hogy bozontosabb embertársaink közös életterünkbe hullatják a szőrüket (és úgy telebundázzák a vécéülőkét, mintha egy mókust tartanának a mogyoróik mellett), mindaddig, amíg az alsó szomszéd bog haja miatt a felső szomszéd kulája nem a mi budinkból szól ki, hogy heló.

|

| Forrás: Amazon JINF |

De kozmikus értelemben, is mindenki csereberéli az alkotóelemeit, amelyeket elcsépelten csillagpornak szoktunk mondani, mert zömmel valóban csillagokban született alkotóelemekről van szó, ami állandó körforgásban van a Földön (és hosszabb távon az Univerzumban). Ezért szokták mondani, hogy mára nagy valószínűséggel sokunkban van olyan vízmolekula is, amelyiket valamelyik római császár pisilt ki egy orgia után.

Kiszuszogunk pár széntartalmú molekulát, amit fotoszintetizál a paradicsom, aztán valaki megveszi a piacon és beépíti a szervezetébe. Aztán valamikor, lehet ha csak halála után, továbbadja, de hiszen tudjátok, sírján fű nő, azt a tehén lelegeli ésatöbbi... Az átlagos emberi test 10^27 (tíz a huszonhetedik hatványon) nagyságrendű atomot tartalmaz, ami az univerzum csillagainak a számával hasonló nagyságrend, nem túlzás tehát az, hogy minden ember egy külön Univerzum. És ennek az atommennyiségnek jelentős részét sűrűn cseréli is az ember, míg például a csontokban megkötött atomokat viszonylag ritkábban.

|

| Forrás: Amazon JINF |

Nagyobb részünk baktériumok, vírusok, atkák, mindenféle jószágok lelkes kommunája, tehát egy random Kovács Bélabácsi, egyetlen emberből és 10.000 különféle egyéb életformából áll, de úgy, hogy az emberi sejtek száma semmilyen becslés szerint sem haladja meg a nem emberi sejtek számát. Most abba ne is menjünk bele, hogy többségünk mekkora nagy szarzsák, nem véletlenül oktatott minket, süldő legénykéket, Vén Farkas annak idején, hogy a legjobb nőben is két kiló van ebből az anyagból.

Tehát minden ember egy hatalmas életközösség, nagy része boldog szimbiózisban, egy univerzum, amiről óhatatlanul lepotyognak élőlények, és rátapadnak újabbak másokról. Ahogyan egy denevérről, a tobzoskán át, rá a kínaira. És akkor itt érünk vissza a bevezetőhöz. Nem az a baj, hogy a levegőn üzekedünk, hanem hogy közben mindjárt kilenc milliárdan leszünk. És emiatt összeér a szimbolikus fenekünk. Na ez az egészségtelen. És akkor már csak nézőpont kérdése, hogy a vírusra kell gyógyszert keresni, vagy a vírus maga egy bizarr gyógyszer, aminek ugyan a hatása nem túl erős, ellenben sok a káros mellékhatása.

Teljesen világos, hogy a COVID-19 kapcsán felmerülő kötelező maszk-használat két némileg ellentmondó paradigmán alapszik. És most hagyjuk azt a burleszket, amit a járvány elején előadtak a véleményvezérek a maszkviseléssel kapcsolatban. Mi nem megyünk bele olyan tudományos és látszólag tudományos vitákba, hogy hasznos e a maszk és hogy magunkat, vagy mások édes jó anyukáját védjük e vele. Azt sem vitatjuk, hogy bárki a házában, üzletében elvárhatja a vendégeitől a maszk használatát. De a szabadban előírni a maszk használatát nincs jogotok! Beleszülettünk egy olyan rabságba, ahol a közös fórumainkon ágyékunkat takargatni kell. Bugyit húzattatok elődeink fenekére. Most meg a mi fejünkre? A számra azért ne... csak az arcomra ne! Azt én akarom eldönteni, mikor jött el az ideje annak, hogy maszkot húzzak a fejemre. Ne siettessétek a pillanatot.

2020/10/19

Legyetek RAW diggerek!

Tényleg olyan sok adat van a RAW-ban? A *.NEF tömörítése.

Egy alapos Utazások olvasónak, amilyenből talán egy sincs (még Grimpix se), igazán feltűnhet, hogy az évek múlásával egyre több dologról derül ki, hogy az nem is pont úgy van, mint arról régebb írtunk. Ez azért van, mert minél egyszerűbbek vagyunk, annál egyszerűbbnek látjuk a világot. Vagy a google vázolta eddig a durvább tónusokat és ahogy haladunk az úton, csak adagolva keni fel az apróbb nüanszokat az összképre.

A D5000-ben sajnos nem kiválasztható a veszteségmentesség. De konkrétan mi lesz a veszteség? Itt az áll, hogy a D5000-nél például a 12 bites 4096 tónust 769 tónusból megoldja.

|

| RawDigger lineáris hisztogram egy D5000-es stúdiófelvételén. Jól látszik, hogy nem volt jobbra exponálva, a felső tartomány teljesen kihasználatlan. Trehány munka, de nem mi készítettük. |

A 114-es sötét értéktől (-2EV tartománytól) felfele kezdi gyomlálgatni ki a köztes tónusokat, eleinte csak minden másodikat, de a végén már csak minden ötödik értéket tartja meg. Azért ritkítja jobban a világosabb tónusokat, mert talán látásunk sajátossága okán a sötétebb tónusokban hamarább észrevennénk a trükköt? Ezt régebb úgy fogalmaztuk meg, hogy egy, illetve két gyertya fényerejében simán észleljük a különbséget, de egy, vagy két atomvillanást már nem tudnánk megkülönböztetni. Ezt egyszer, ha lesz atombombánk, majd tesztelni is szeretnénk. Meg hát ez még lineáris állapot, a legfelső egyetlen fényérték (+3EV) akkora helyen van tárolva, mint az összes alatta levő (2048 lépés), tehát ebből lehet a legjobban pancsolni, az alatta levő fényérték meg akkora, mint az összes alatta levő (1024), tehát ebből már kevésbé érdemes eldobni, és így lefele végig, 114 alatt már minden egyes tónust eltárol (már ez is kevés). Grafikonra téve elég lehangoló:

Tehát -3EV alatt a 12 bites konverterből kijövő adat 100% kerül tárolásra, aztán ez a +3EV tartományig fokozatosan leesik 10,69%-ra. -8EV-től felfele minden tartomány duplája az azelőttinek, de -3EV-tól fokozatosan esik ez az érték, 1,9-szerese, 1,5-szöröse és végül csak 1,41-szerese az azelőttinek. Pedig mi mindig úgy fújtuk az elméletet, hogy felefelé végig duplázódik a tónusok száma. Hát nem.

Mindezt miért? Gyorsabb írás, nagyobb framerate, ilyenek miatt. Egy D5000 kb. 4288*2848 pixeles lapkája 12,2 millió pixelnyi 12 bites adatot termel, durván 18 Mb. Ennyi lenne egy tömörítetlen kép, persze ehhez még csomó apróság hozzáadódik, jpg előkép, meta, stb. Ezzel szemben egy NEF nekünk 8-10 Mb között szokott lenni. Persze még egy veszteségmentes tömörítést is kap a kép, ami még jobban árnyalja a dolgokat.

Érdekes korreláció, hogy a világosabb képek kicsit nagyobbak, mint a sötétek, Tehát ha egy szürke lapot végigexponálunk pl. -3 és +3 EV korrekcióval, akkor egyre nagyobb fileméretet kapunk, mindaddig, amíg a felülexponált képeken nem kezd kicsúszni a 4096-ból, ami +4EV korrekciónál már bekövetkezik a mi gépünkön, innen ahogy haladunk tovább megint egyre kisebb fileméretet kapunk. Lehet, hogy a sötétebb tónusokat eleve kevesebb bittel írja le?

2020/10/16

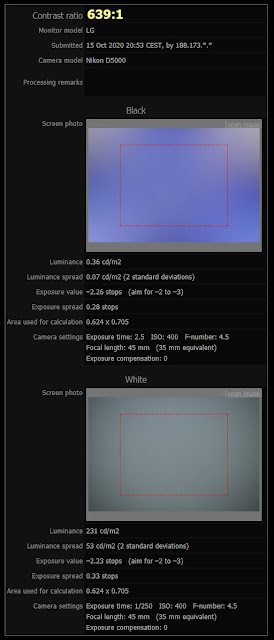

Monitor monitorozás

Volt már ilyen az Utazásokban, azonban most egy másik panelt elemzünk. Itt akár abba is hagyhatod az olvasást, és inkább tégy egy kirándulást erre az oldalra, ahol remek tesztek, meg optikai illúziók várnak, természetesen a saját monitorodnak megfelelő megjelenítésben. Ez meg egy másik monitortesztelgetős oldal, amellett, hogy jó játék, talán némi ismeret is ránkragad közben.

Tehát ezt írják a gyártó oldalán (bővebben itt):

Screen Size Class. Miért "Class"? Hát mert a 27 coll körülbelül 26,9. De legalább közel áll hozzá.

IPS panel, ami állítólag sokkal feketébb feketét tud, mint a többiek, illetve a betekintési szöge is olyan széles, hogy nem kell megbillenteni a fotel magasságához.

A Gamutot itt tárgyaltuk részletesebben. sRGB 99%. Nem egy nagy szám manapság.

Pixel Pitch, 595 milliméteren 3840 pixellel ez 0,1549, de ki számolja. Ez a pixelsűrűségben 163,9 szemben az általuk megadott 163-as értékkel. A marketinges elaludt, pedig ezt még én is felkerekítettem volna.

2020/10/15

Forgatások

Összességében azt gondoljuk, hogy a négylépéses módszer négy lépésben roncsolja a képet újabb interpolációkkal, míg a forgatás, bár nem kizárt, hogy a háttérben több lépést hajt végre, de semmiképpen sem ugyanezeket. Ebből meg annyi a tanulság, hogy finom textúrák esetén érdemes odafigyelni, hogy milyen módszerrel állítunk vízszintet egy képen. Sajnos az ACR straighten vízszintező módszeréről semmit sem találtunk, de a RawTherapee összes Transform műveleténél kiválasztható a linear vagy a logarithmic. Szóval érdemes próbálgatni, de sosem lehetünk biztosak, hogy egy adott nagyításnál szemlélve a tetszetős eredmény, más méretekben is pont jó lesz.

2020/10/13

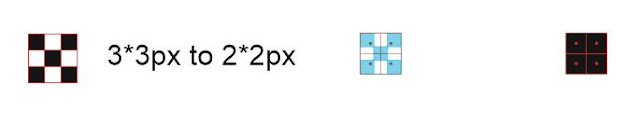

Tőszomszédok - Nearest Neighbor

Fogadjunk, amíg nem gondolkozol el rajta, azt hinnéd a képek zoomolgatása, legyen az monitoron, vagy telefonon, egy banális művelet, széthúzod ujjbeggyel, vagy kontroll-pluszmínusz és kész. Az is világos, hogy egy digitális kép nem nagyítható akármekkorára, vagyis a filmekben, a megfigyelő kamera két pixeléből sem a CIA, sem az MI6 nem tudja kinyerni az elkövető kilétét, de aki kicsit érdeklődő, az már hallott arról is, hogy az AI megjelenésével ez valamennyire mégsem teljesen kizárt.

Éppen ezért a különféle célokra különféle módszereket fejlesztettek. A legegyszerűbb eset, ami a cím is (amivel a neten a legtöbbet fogsz találkozni, mert majd hülyék lesznek az influenszerek sérvet kapni a problémásabb interpolációktól), az amikor a képet, kétszeresére/négyszeresére/stb. növeled. A tőszomszéd algoritmus ilyenkor nem csinál mást, mint minden pixelt megdupláz (mindkét irányba), ahol eddig egy - mondjuk fekete pixel volt, ott most négy vagy nyolc fekete pixel lesz.

2020/10/10

Russell Kirsch lépcső alakú pixelei

|

| Forrás |

Valahogy úgy képzeljük ezt el, ahogyan az ofszetnyomtatásban a raszterpontot, azt is 16*16 vagy egyéb felbontású mátrixban képezik. Persze az így keltett háromszög (lépcső), meg osszefordított L-betű alakú pixeleket 36 apró szubpixelből kell megképezni, de ezt csak egyszer kellene leírni és sokszor fel lehetne használni a képen (itt sejtünk némi rokonságot a JPEG tömörítéssel), emiatt kevesebb adat kellene a teljes képhez. Pont mint a fenti mozaikon, ugyanannyi darab mozaikból, mint négyzetes pixelből, sokkal jobb felbontás elérhető. Persze, csomó része nem világos a modellnek és nem is nagyon hozzáférhetőek a Mester cuccai. Emiatt nem tudhatjuk, hogy amellett, hogy számtalan előnye lenne (pl. moiresodás kiküszöbölése, forgatás), nem e okozna előre nem látható problémákat. Mindenesetre izgalmas, és a szimulációja, amit szintén a fiáról készített (mint a legeslegelső szkennelt képet a világon), elég meggyőző:

| Forrás a vimeóból. A jobboldali kép a fennebb mutatott változó pixeleket használja, szemben a baloldali hagyományos, négyzet alakúval. |

Visszatérve a legelső képre, a mozaikra. Erősen szemléletes, de egyáltalán nem fair összehasonlítani egy mozaikot és egy arról készült pixeles képet. Ugyanis a mozaikok pontosan úgy vannak lerakva, hogy kontúrokat alkossanak, a pixeleknek ez nem áll módjában lekövetni. De így legalább kipróbáltuk a Mozaik és Crystal szűrőket, nyilván ez nem ugyanaz és semmit sem állít a változó pixelekről, csak pont ez jutott eszünkbe a témáról. Vagyishogy nagyon gyenge felbontás esetén vajon jobb eredményt ad e a mozaikszerű (random alakú és elrendezésű) pixel, mint a négyzetes. Mindkét szűrőt 8 pixel értékre állítottuk, így nagyjából a felbontás is hasonló. Mint látható, nem azon múlik, hogy a pixelek ne négyzet alakúak legyenek, hanem ki kell azt rendesen találni, hogy milyen alakú pixelek hogyan is rendeződjenek. Minket itt meghalad a dolog, de nem bánjuk, hogy megismertük Russell úr gondolatait, hisz ő is egy olyan óriás, akinek a válláról ma fotózhatunk.

2020/10/08

Létezik analóg fotózás, és ha igen, miért nem?

Milyen alakja van a pixelnek? Kocka? Négyzet? Kör? Gömb? Esetleg pont?

Miért, milyen alakú a foton? Grimpix szerint a foton inkább gömb, de semmi esetre sem kocka alakú, mert ha nem lapjával, hanem például egyik sarkával esne a szemedbe, az nagyon fájna. Na jó, az éles fény, éjjel, amikor kimész a budiba, az lehet ha dobócsillag alakú. Azért fáj. Vagy a lézernek tutti, hogy százasszög az alakja. Azért szúrja ki a szemedet. Vagy a minap a szoliban az UV-nek meg sarokcsiszoló volt az alakja, le is reszelte a bőrömet mindenhonnan. Na, hogy ezt így megbeszéltük, haladjunk.

|

| Káoszkép tintasugaras nyomaton mikroszkóp alatt. Ha hiszed ha nem, ez egy sakktábla minta. |

Az imént említett méréssorozatot, ha eltároljuk, mondjuk mérésenként 32 biten, akkor azt hívjuk digitális képnek. Eltárolva aztán sokféle alakja lehet, merevlemezen valamilyen mágneses jelek körcikkek dirib-darabjaiba rendeződve, SD kártyán a jóisten se tudja milyen hosszú adatsorok tranzisztorokba zárt töltések formájában, és ha hozzávesszük, hogy a pixelek esetleg JPEG tömörítéssel vannak kiírva, akkor kismillió átfedés is lehet a pixeladatok között a hordozón. Tehát eltárolva inkább ne firtassuk a pixel alakját, mert a formához érzékszerv kell (látás, tapintás), de a digitális adat nem is látszik és nem is tapintható. Mondjuk optikai lemezen pont látszik, lyukkártyán meg tapintható.

|

| Forrás - valahogy így nézhet ki DVD-n a pixel. |

|

| A pixelek így néznek ki a Corel digitális terében |

Na jó, de mi van, ha át akarsz térni az analóg térbe (akármit is jelentsen ez most)? Hogyha ezt a digitális képet ki akarod nyomtatni egy tintasugaras nyomtatóval, akkor egy pixelt sok-sok tintapötty (droplet) fogja alkotni. Hogy ez a droplet lecsöppenő takony formájú, vagy tökéletes gömbbé válik a papírba becsapódás előtt, tökmindegy. A papír rostjaiban leginkább szabálytalan alakú térbeli paca lesz egy-egy képpont, amiből jó sok alkotja meg az eredeti képünk egyetlen (diszkrét) képpontját.

|

| Kinyomtatva tintasugarason 300 ppi-vel meg így néznek ki. |

Megint más eset, hogyha ugyanezt a képet ofszet nyomtatásban, teszem azt 175 LPI ráccsal akarjuk kinyomtatni. A raszterpontok elrendeződése lehet rácsos (vonalpár) valamilyen szög mentén, de lehet szabálytalan elhelyezkedésű is, ezt hívjuk sztohasztikus rácsnak. A raszterpont alakja is sokféle lehet, kör, gyémánt, figyelembe veheti a pontnyúlást, de végső soron a raszterpont tovább bontható subraszter pontokra.

|

| Ez a rács például 150LPI és 2400dpi, egy DotTiff részlete kinagyítva a digit. |

|

| 2400dpi - 175 LPI egy ofszetlemezen. |

2020/10/02

A QR-kód halott, de élvezi

Nem, egyáltalán nem voltak illúzióink, hogy a csomagolóipar majd felismeri a QR kódok igazi lehetőségeit a költségcsökkentésre, és a környezettudatosságra. Mert a marketingnek ezek nem szempontok. Hogy ne hét nyelven (mert hétféle csomagolást mégsem lehet csinálni) hangyabetűkkel írják fel, amit 40 fölött már kihívás szemüveg nélkül elolvasni, hanem csak tegyenek rá egy QR-kódot, aztán mindenki a saját telefonján babrálja, legalább azalatt sem a facebookot görgeti. Vagy például a lepedő nagyságú gyógyszer-prospektusok helyett is lehetne a csomagolásra nyomni egy pár négyzet-centiméteres QR-t. Ami mellesleg még szép is tudna lenni. A sok favágó, papírmunkás, nyomdász meg elmehetne webdesignernek.

Ellenérvnek felhozható lenne, hogy akkor a funkcionális analfabéták hogyan fogják megnézni hogyan hat a pirula, vagy hogy gluténmentes e a csoki? Hát az igazi analfabéták meg hogy? Na ugye?

|

| QR creator - kicsit fapados, de ingyenes. |

Aztán a másik, amit nem értünk, hogy minek kell erdőn-mezőn a tanösvények mellé (sok eus pénzből) hatalmas nagy paneleket kihelyezni, amiről aztán a szél kifújja, nap kiszíjja a színeket. Hát minek nem lehet csak egy szerény kis QR-kódot felszegezni, aztán aki akarja, az olvasgassa, az őzikéket meg nem baszná fel az ideg ahányszor csak futtából lefejelnek egy ilyen korhadó fa-monstrumot. Ennek némileg ellent mond az, hogy például a Vargyas-szorosban több a medve, mint a 4G, úgyhogy ott ne mind telefonozzatok, inkább figyeljetek oda, nehogy a lábára lépjetek a macinak.

|

| A Visualed QR-gyártó elég aljadék módon ingyenes. Ha beolvasod meglátod. Mellesleg máris megértetted, hogy milyen a dinamikus QR. |

A virtuális üzlet viszont szerintünk marhaság. A marketing egy újabb opportunista fattya. Ha valamit online akarunk vásárolni, akkor azt anélkül is megkereshetjük és megvehetjük a neten, hogy egy aluljáróban a pofánkba nyomnák a reklámot, meg amúgy is reklámellenesek vagyunk. Ha meg hazafelé jut eszünkbe, hogy nem vettünk kenyeret, akkor pont olyan macera egy olyan virtuális üzletet találni, ahonnan szkennelhetünk egy QR-kenyeret magunknak, mint egy igazi pékséget. Aztán van például a Munzee, ami a mára jóformán kihalt geocachingnek és a pokemon-vadászatnak valamiféle hibridje... biztos jó, annak aki szereti.

A QR számomra úgy tűnt szinte kihalt (nálunk), de valamiféle folytonossága csak van, mások szerint még nem is jött el az igazi adventje és csak én vagyok türelmetlen (60 éve létezik és legalább 10 éve van mindenkinek okostelefonja). Na, de minket csupán a technológiája érdekel, mint a bárkódoknak.

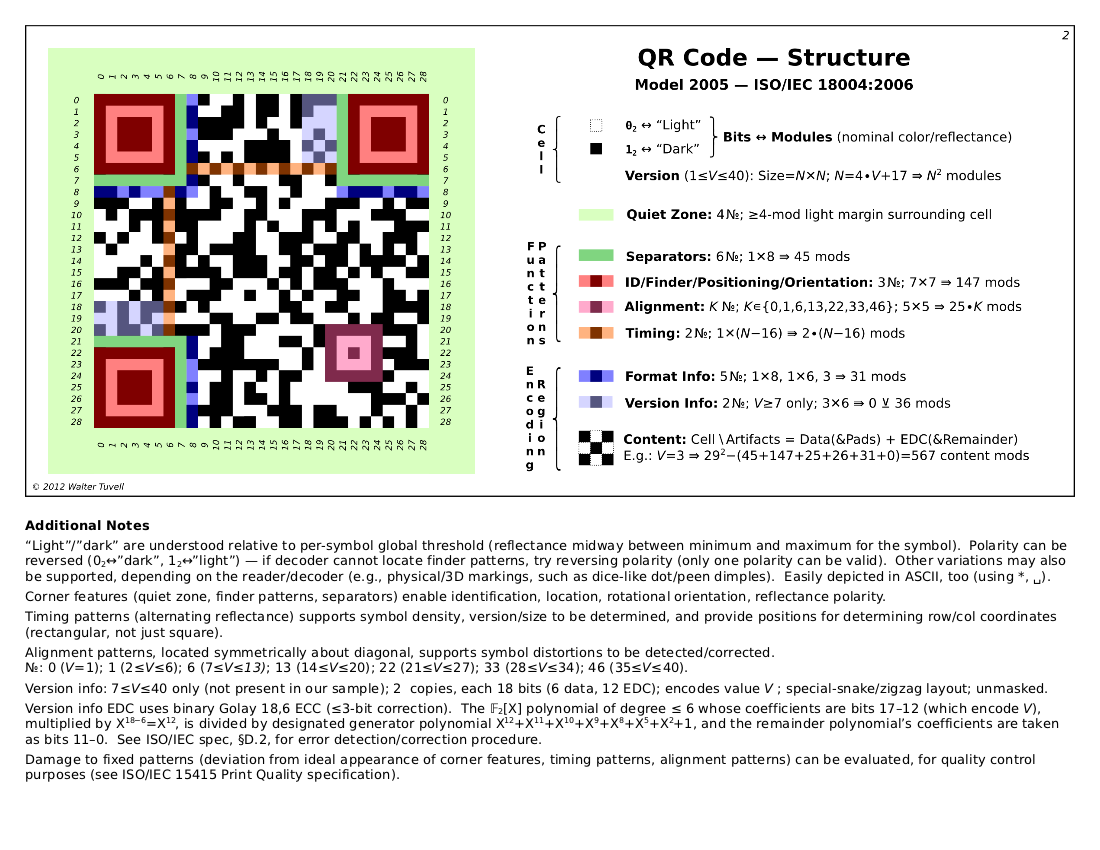

A kétdimenziós kódoknak, közöttük a QR egyik nagy előnye, hogy sérült állapotában, rossz fényviszonyok és random betekintési szög mellet is elég jól beolvasható. Tehát képes a sérült/hiányzó adat helyreállítására bizonyos keretek között. Ehhez nyilván valamennyire redundánsnak (forward error coding) kell lennie. A QR a Reel-Salomon módszert használja, amibe most nem megyünk bele.

Főbb elemei, a három sarokjel, csendzónával körülötte. Pászítójelek (minél nagyobb a kód annál több), timing-sorok, formátum, verzió és hibajavító-szint információk. Az összes többi mező maga az adat.QR alapok, lépések, amelyek a QR-kód generálásához szükségesek.

Tehát már tudjuk, hogy milyen módon, mekkora redundanciával kell kódolni. Ez megadja, hogy mekkora mátrixon lehetséges a kódolás. A különböző méretű QR kódokat verzióknak nevezik. Jelenleg a 40-es verzió 177*177-es mátrix a legnagyobb, ez nagyjából egy A4-es lap teljes szövegét képes tárolni (L-es hibajavítás mellett, 4296 karakter - a kapacitás a kódolási módtól függ, csak számokból több mint kétszer ennyi is lehet: 7089 szám - nyilván M, Q és H hibajavító szinteken ennél kevesebb adat tárolható). QR: 40-es verzió esetén legfeljebb 16 bitet használ arra, hogy a kódolt karakterek számát megadja.

Ezután binárissá alakítja az adatot.

Numerikus esetén 3-as csoportokra bontja a kódolni kívánt számot, ezeket binárissá alakítja (a 999-es legnagyobb háromtagú szám 10 biten kódolható, tehát egy szám 3,3 bitet foglalhat el). Például az 1977-es szám 197 és 7 felbontva, vagyis binárisan: 1100 0101 illetve 111.

Alfanumerikus esetén (csak nagybetűk) karakterpárokra bontja a szöveget. Ezeket az alfanumerikus tábla alapján megfelelteti kétjegyű számoknak. Mivel az alfanumerikus tábla 44 elemű, ezért a karakterpárokat úgy alakítja számmá, hogy az első számot felszorozza 45-tel, majd hozzáadja a második számhoz. Ezután pont mint a numerikus esetén binárissá alakítja ezeket a számokat. Például a GRIMPIX így bomlik:

PI - 25, 18 amiből 45*25 + 18 = 1143 vagyis 100 0111 0111

X - 33 amiből 33 = 10 0001

Tehát karakterenként 5,5 bit kell, mivel két darab kettőspont (44-es a tábla szerint) már például csak 11 biten kódolható (45*44+44 egyenlő 2024).

104-48 bit az 56/8 vagyis 7 pad byte kell még: 11101100 00010001 11101100 00010001 11101100 00010001 11101100

A teljes kód-kolbász tehát, ha valamit el nem rontottunk közben, tehát 13 byte (104 bit):

00100000 00111101 11010111 10100000 01000111 01110000 11101100 00010001 11101100 00010001 11101100 00010001 11101100

A QR-kód négy hibajavító szintje (L, M, Q, H) például a keremarkan interpretálásában így néz ki balról jobbra, ha blogunk címét kell megjeleníteni:

A wiki szerint a négy szint 7-15-25-illetve 30% hibát képes visszaállítani, de nem tudjuk, hogy ez a teljes kódra, vagy csak az információra vonatkozik e. Mindenesetre a 27*27-es mátrixon (729 mező - L vagyis 7% hibajavítás) egy 30 - 32 mezős maszkot szinte bárhová tehettünk, képes volt visszaolvasni, de a pászítójelek és a körülöttük levő csendzóna csak néhány mezejének letakarásával is olvashatatlan lett az egész. A spacer, verzióinformációk, illetve a hibajavító szint információit viszont letakarhatjuk, nem zavarja a visszaolvasást.

Érdekesség, hogy esetünkben a kód 27-31-31-35-ös mátrixokból áll, tehát az M és a Q biztonsági szint között nincs méretnövekedés (verzió növekedés). Elképzelhető, hogy az M nem használja ki a 31-es mátrix lehetőségeit - mint az előbb, amikor a GRIMPIX szöveget padbyteokkal töltöttük fel - a Q meg még pont elfér benne. A QR hibajavító szintjét amúgy a bal alsó sarok két pöttye mutatja, de úgy tűnik nincs szüksége rá a kikódoláshoz, ugyanis ha ezt letakarjuk, attól még simán kikódolja.

|

| Forrás |

Kétféle generátorral, hasonló beállításokkal, ráadásul nem is ugyanazt a mintázatot kapjuk, bár a mátrixméret meg a kinyert és megjelenített link tökéletesen ugyanaz.

Mindenesetre, ha otthon felejtenéd az okostelefonodat, nem érdemes papírlappal, számológéppel és ceruzával nekiállni megfejteni egy QR-kódot. Az viszont elgondolkoztató, hogy szabad e az információhoz való hozzáférésünket ennyire kiszolgáltatni a robotoknak. Másképpen fogalmazva, egy robot-hatalomátvétel esetén nem e szakadunk el hirtelen és végérvényesen a digitalizált információinktól? Avagy mennyire lehet igazán fontos az olyan információ, amihez a hozzáférésünket egy képelemző algoritmus végezheti.

Vegye meg a QR-kód leírását, akinek van erre a hülyeségre ennyi pénze.